Wanneer je op de spoedpost arriveert met een gebroken bot dat zichtbaar uit een gapende wond steekt, dan ben je beter af met een ervaren trauma-arts dan met kunstmatige intelligente software. Maar voor een groot aantal minder acute medische toepassingen blijken digitale dokters nuttig te zijn, en in sommige gevallen zelfs beter te presteren dan mensen. Die razendsnelle opkomst van zogeheten artificial intelligence (AI) wekt beloften, maar roept ook veel vragen op, zeggen ethici. SmartHealth sprak met prof. Maartje Schermer.

Het Centrum voor Ethiek en Gezondheid (CEG), een samenwerkingsverband van de Gezondheidsraad en de Raad voor Volksgezondheid en Samenleving, publiceerde afgelopen week een zogeheten signalement dat probeert de ethische aspecten van computersoftware die medische taken uitvoert in kaart te brengen. Het signalement heet Digitale dokters, een ethische verkenning van medische expertsystemen. In eerste paragraaf wordt direct de toon gezet: "De verwachtingen van medische expertsystemen zijn groots, maar vooralsnog worden die verwachtingen niet waargemaakt.”

“Die hooggestemde verwachtingen zijn een algemeen beeld bij technologische ontwikkelingen”, zegt professor dr. Maartje Schermer. Zij is bijzonder hoogleraar Filosofie van de geneeskunde (ErasmusMC) en voorzitter van de CEG-commissie die verantwoordelijk is voor de uitgave.

Prof. Maartje Schermer

Het in het signalement geconstateerde verschil tussen verwachtingen en werkelijkheid is een subjectief oordeel, dat niet op uitgebreid wetenschappelijk onderzoek is gebaseerd, erkent Schermer desgevraagd. Het geeft volgens haar wel aan dat ook op andere plaatsen waarschuwende woorden te horen zijn over onrealistische verwachtingen dat de computer op korte termijn de dokter kan vervangen.

Medisch expertsysteem?

Waar hebben de auteurs het over? Medische expertsystemen zijn gebaseerd op kunstmatige intelligentie die artsen of andere zorgverleners kunnen assisteren bij bijvoorbeeld bij triage (indeling van patiënten naar ernst van een ziektebeeld) of bij het opstellen van een prognose, diagnose, medicatieplan of behandelvoorstel.

Volgens het CEG zijn er twee smaken te onderscheiden in medische expertsystemen: software met ingebouwde regelgebaseerde (rule-based) redeneermechanismen, en software die zelflerend (machine learning of het meer geavanceerde deep learning) te werk gaat. Regelgebaseerde medische systemen bestaan al een aantal decennia, en worden geprogrammeerd met behandeladviezen en medische richtlijnen als basis. Een voorbeeld is Oncoguide, ontwikkeld door het Integraal kankercentrum Nederland (IKNL). Dit systeem genereert via ‘beslisbomen’ patiëntspecifieke behandeladviezen, op basis van (ziekte)gegevens van de patiënt uit het elektronisch patiëntendossier en Nederlandse oncologische richtlijnen. Verandert de richtlijn, dan verandert het systeem ook.

IBM Watson

Dit kunnen ook relatief simpele regelgebaseerde systemen zijn, zoals een geautomatiseerde waarschuwing in een EPD als er een gevaarlijke interactie dreigt tussen twee voorgeschreven medicijnen. Daar tegenover zet het CEG een zelflerend systeem, dat niet door mensen wordt voorgeprogrammeerd zoals een regelgebaseerd systeem. Een zelflerend systeem ‘leert’ en neemt beslissingen op basis van patronen in de beschikbare data.

Trainen met data

Maar die data vormt tegelijkertijd een belemmering, aangezien ‘zelflerende’ expertsystemen gevoed moeten worden met (trainings)data. Een oncologische expertsysteem kan bijvoorbeeld getraind wordt met data uit een elektronisch patiëntendossier en aanvullende patiëntinformatie, zoals DNA- of genetisch onderzoek. Maar die data zouden wel eens minder representatief kunnen zijn voor andere (minder complexe) patiënten, buiten de context van een gespecialiseerd ziekenhuis, suggereren de auteurs.

Zeker bij gegevens die niet uit randomised controlled trials verkregen worden, kan vertekening niet worden uitgesloten. Dat probleem speelt met name voor zelflerende systemen, omdat bij die systemen niet duidelijk is welke gegevens zijn gebruikt, concludeert het signalement. “Zelflerende systemen kunnen weliswaar ‘grote hoeveelheden data’ verwerken maar daarvoor moeten ontwikkelaars wel toegang hebben tot die data, en die toegang is natuurlijk nooit volledig”, stellen de auteurs. En zelfs als dat wel zo is, wie bepaalt welke gegevens wel en niet beschikbaar worden gesteld voor het systeem? Wat volgens het signalement zeker niet bijdraagt aan de discussie is weinig openheid die bedrijven als DeepMind en IBM geven in de werking van hun technologie.

Ethische vragen

Maartje Schermer benadrukt dat het CEG niet vindt dat we pas op de plaats moeten maken met de ontwikkeling van deze technologie, voorzover een klein land als Nederland dat al zou kunnen. “Bij de invoering van deze technologie zijn allerlei partijen betrokken die een belang kunnen hebben dat niet hetzelfde hoeft te zijn als dat van de patiënt of consument. Wij vinden het belangrijk dat we voor de klakkeloze invoering ervan aandacht vragen voor mogelijke bijeffecten of nadelige gevolgen.

Schermer vindt het belangrijk dat gebruikers inzicht hebben in de manier waarop zo’n systeem tot een diagnose of behandelvoorstel komt. “Je moet immers kunnen beoordelen of een behandelvoorstel van een expertsysteem medisch en ethisch te verdedigen is.”

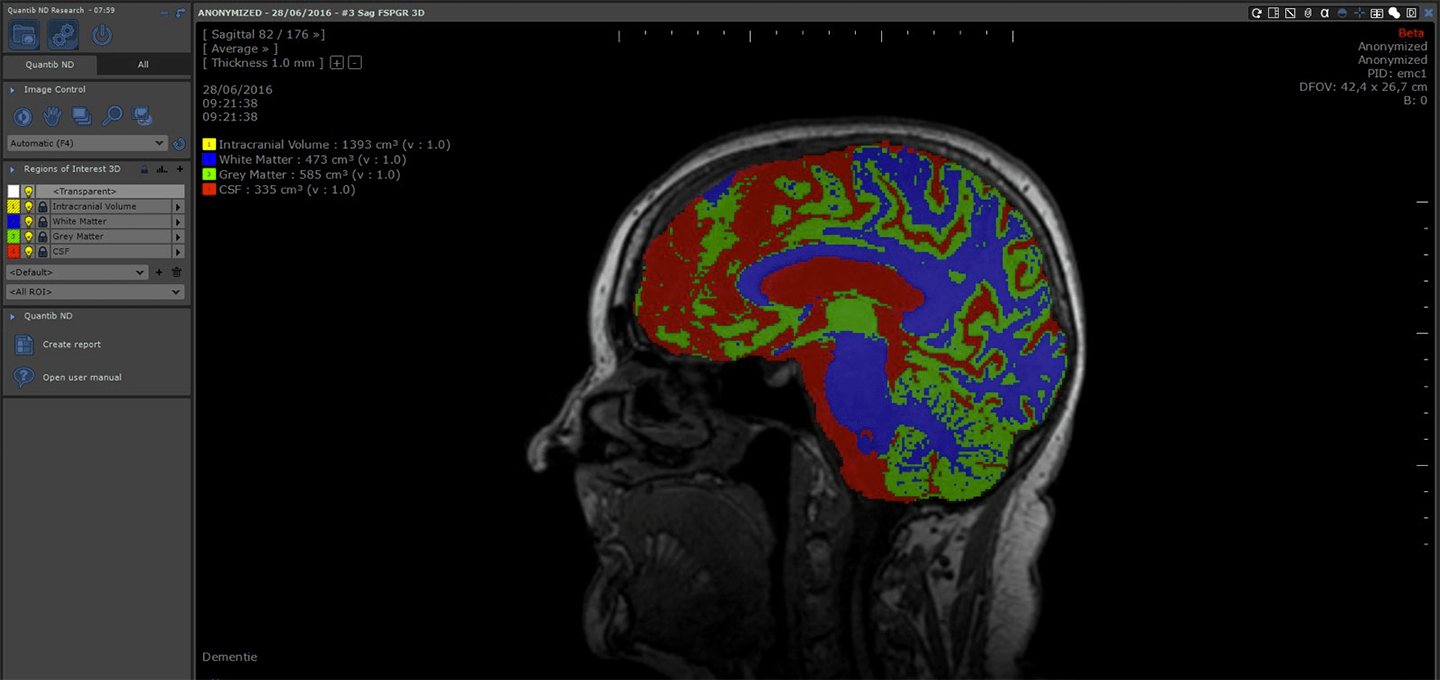

Quantib software voor hersenonderzoek

Het signalement besteedt daarnaast aandacht aan de veranderde rol van de arts bij het gebruik van expertsystemen. Hoe staat het met hun professionele verantwoordelijkheid wanneer ze een waarschuwing of advies van een systeem niet opvolgen, bijvoorbeeld omdat ze het in een bepaalde situatie niet toepasbaar vinden? Schermer: “Een andere interessante vraag is of het wel ethisch is om expertsystemen niet te gebruiken wanneer die voor bepaalde taken aantoonbaar beter presteren dan menselijke artsen.”

De inzet van expertsystemen zal van invloed zijn op de relatie tussen de arts en de patiënt, verwachten de auteurs: “Als expertsystemen een grotere rol zullen spelen bij het identificeren van behandelopties, dan rijst de vraag hoe ze zich zullen verhouden tot de afwegingen van de individuele patiënt, en zijn wens om de eigen regie te voeren." Volgens Schermer geldt ook hier dat arts en patiënt te allen tijde inzicht moeten hebben in de manier waarop prognoses of adviezen tot stand komen en wat de doelen zijn, bijvoorbeeld langer leven of een hogere kwaliteit van leven.

"Vragen in ieder geval benoemen"

Het signalement eindigt met vragen rond privacy en aansprakelijkheid, zoals deze: “Als artsen en patiënten in de toekomst meer taken delegeren aan expertsystemen, en er meer ‘automatisch’ op vertrouwen, moeten de ontwikkelaars van expertsystemen dan niet ten minste deels verantwoordelijk gesteld kunnen worden voor fouten?”

Schermer geeft volmondig toe dat de signalement meer vragen oproept dan dat de publicatie antwoorden biedt (ook al is een hoofdstuk met adviezen opgenomen). “In deze fase van deze veelbelovende technologie is het vooral belangrijk om ethische vragen en overwegingen te signaleren die door andere belanghebbenden, zoals de software-industrie, niet vanzelf aan de orde worden gesteld. Dat geldt ook voor de veranderende relatie tussen artsen en hun patiënten. Het is belangrijk dat die vragen in ieder geval benoemd worden.”

De publicatie is hier te downloaden

Plaats een Reactie

Meepraten?Draag gerust bij!